Dual Hypergraph Convolution Networks for Image Forgery Localization

英文题目:《Dual Hypergraph Convolution Networks for Image Forgery Localization》

中文题目:《双超图卷积网络用于图像伪造定位》

论文作者:Jiahao Huang , Xiaochen Yuan , Wei Ke , and Chan-Tong Lam

发布于: ICPR

发布时间:2024-12-04

级别:CCF-A

论文链接:http://dx.doi.org/10.1007/978-3-031-78312-8_22

论文代码:暂无

摘要

图像编辑技术的不断进步使得伪造图像更容易被创建。不当使用可能导致伪造图像泛滥。为了检测和定位伪造图像中的伪造区域,现有研究利用各种特征视图来捕捉细微的伪造痕迹。然而,**伪造图像表现出复杂的高阶关系,例如区域间的群体相互作用。这种相互作用反映了区域间的不一致性。**因此,我们提出了一种新颖的双超图卷积网络 (DHC-Net),通过使用超图表示群体相互作用来增强伪造区域的定位。DHC-Net 构建区域和边缘超图卷积分支,以优化伪造区域的定位。我们在四个广泛使用的公共数据集上验证了 DHC-Net,包括 CASIA1.0、NIST、Columbia 和 Coverage。结果表明,所提出的 DHC-Net 实现了更高的定位精度。

本文聚焦的问题

随着图像编辑技术的发展,造假图片越来越容易生成(比如拼接、复制粘贴、修补)。这些伪造图片可能被用于新闻造假、欺诈等不当用途。现有方法虽然能检测一些细微的篡改痕迹,但往往忽视了不同图像区域之间的复杂关系(比如一组区域之间的不一致性)。这会导致伪造区域定位不够准确。本文关注的核心问题是:如何更好地利用区域之间的高阶关系,提高图像伪造定位的精度?

本文提出的方法

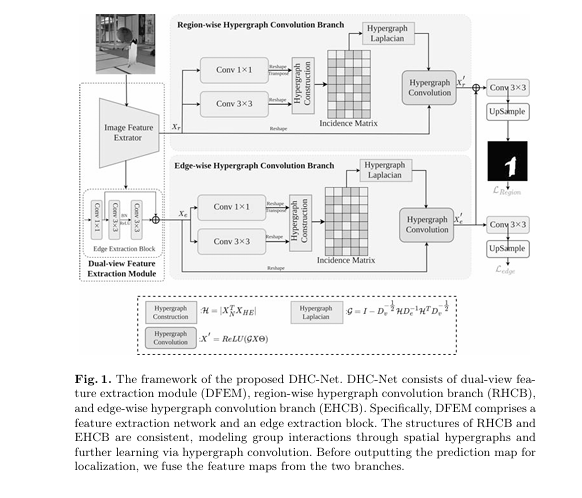

作者提出了一种新的模型 DHC-Net,主要创新点是引入了 超图卷积网络 来建模伪造图像中“区域之间的群体交互关系”。

DHC-Net 的主要组成部分:

- **双视角特征提取模块(DFEM):**使用 ConvNeXt 网络提取图像的高层语义特征,同时通过边缘提取模块获得边缘特征,这样就得到两个视角:区域特征和边缘特征。

- 区域级超图卷积分支(RHCB),把整张图像划分成区域,利用超图来建模这些区域之间的关系,通过超图卷积捕捉不同区域之间的交互特征,从而发现伪造区域。

- 边缘级超图卷积分支(EHCB),专门对边缘特征进行超图卷积,学习伪造区域边界的交互关系。这样可以提高定位时的边缘精度。

DHC-Net 框架执行流程为:首先将输入图像送入 ConvNeXt 提取高层语义特征,并通过边缘提取模块获得边缘特征,形成区域视角和边缘视角两类输入;随后,区域特征进入区域级超图卷积分支,用超图建模多个区域之间的群体交互关系,以发现整体伪造痕迹;边缘特征进入边缘级超图卷积分支,利用超图卷积捕捉边缘之间的交互特征,从而更精细地刻画伪造边界;最后将两路结果融合,经过卷积和上采样得到伪造区域预测图,并在训练中通过区域损失与边缘损失共同监督,从而实现更精准的伪造区域定位。

阅读总结

优点:

- 首次将 超图卷积 引入图像伪造定位,有效捕捉区域之间复杂的群体交互关系。

- 设计了区域级和边缘级两个分支,兼顾整体定位和细节边界,实验效果优于现有方法。

不足与未来方向:当前的超图结构是固定的,可能不能完全适应不同类型的伪造。未来可以探索 动态超图结构学习,让模型根据输入自动构建最优超图。