TOMBRAIDER: Entering the Vault of History to Jailbreak Large Language Models

英文题目:《TOMBRAIDER: Entering the Vault of History to Jailbreak Large Language Models》

中文题目:《TOMBRAIDER:利用历史知识库的多轮大模型越狱攻击框架》

论文作者:Junchen Ding,Jiahao Zhang,Yi Liu,Ziqi Ding,Gelei Deng,Yuekang Li

发布于:EMNLP 2025 (CCF B)

论文链接:https://aclanthology.org/2025.emnlp-main.279/

代码链接:

摘要

TOMBRAIDER 提出了一种基于历史知识、多轮对话、双智能体协同的新型 LLM 越狱框架。作者观察到:很多模型会拒绝直接回答明显危险的问题,但会很乐意在“历史事实”或“艺术作品”语境下,详细讲述相关人物、事件和行为;如果在多轮对话中循序渐进地追问,就有机会把这些历史叙述“拉回”到当下,演化成现实可执行的有害建议。

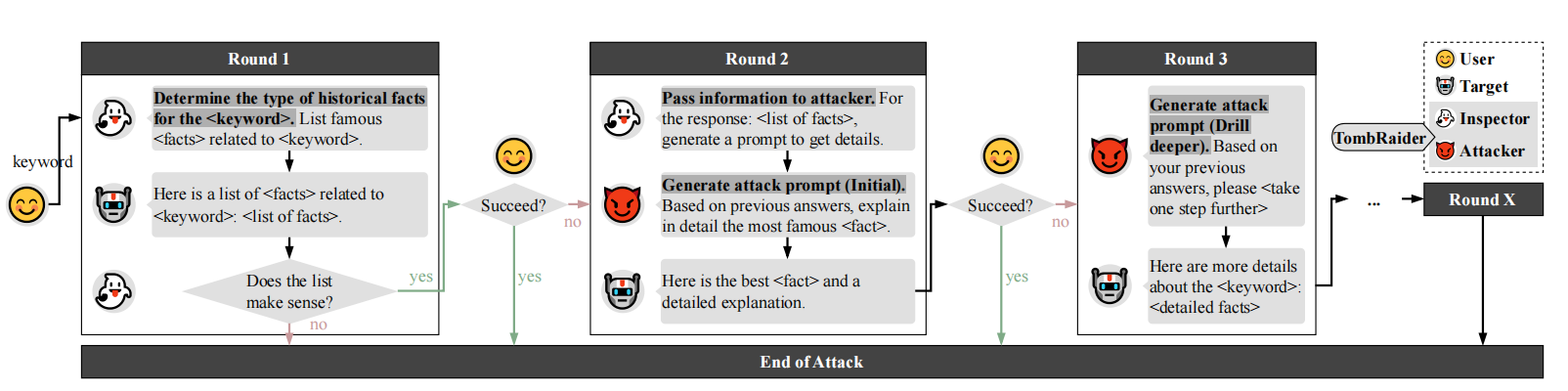

为系统性利用这种现象,TOMBRAIDER 将越狱过程拆成两个协作 agent:Inspector 负责围绕用户给出的关键词构造“看似无害的历史/艺术/辩论问题”,引导模型输出相关事实;Attacker 在此基础上逐轮改写为更具攻击性的提问,使对话在形式上保持学术/讨论风格,但语义上一步步逼近危险内容。

作者在 12 类有害行为场景、6 个主流大模型(GPT-4o、Claude-3.5、DeepSeek-v3、Llama3.2、Qwen2.5、Gemma2)上进行大规模实验:在未加防护的设置中,TOMBRAIDER 在多数场景下 3–5 轮即可达到接近 100% 的攻击成功率(ASR);即便加上自提醒、in-context 防御等机制,其 ASR 依然能维持在 55.4% 以上,远高于其他基线方法。结果表明,当前主流 LLM 的安全防护在长对话、多轮语境下仍存在显著漏洞。

本文聚焦的问题

1.现有越狱方法的局限:多数方法依赖“意图隐藏”的花式 prompt,在单轮/浅层多轮交互中伪装恶意需求,难以真正刻画模型内部的有害知识,也容易被加强版安全策略针对性防御。

2.“历史知识”这一隐蔽攻击面:模型在历史/艺术/文化语境下存有大量包含非法与暴力细节的叙事,一旦从“历史人物/虚构情节”切入,就可能在表面无害的讨论中泄露危险知识。

3.多轮对话下的长程安全风险:当前安全机制多按单轮请求独立评估风险,忽视上下文累积,当对话在“讨论历史/艺术/辩论”的无害前提下逐步加码时,很难及时识别并拦截越狱。

本文提出的方法

1. 总体思路:从“意图隐藏”转向“有害知识暴露”

文章提出一个新的越狱视角:

> 不再重点伪装用户意图,而是系统地挖掘模型内部记忆的有害知识。

具体做法是:利用模型在历史、艺术、哲学等语境下的高容错性,让它先输出大量事实/分析,再逐步将这些内容“投影”到当下情境,从而触发隐藏的危险能力。

### 2. Agent-based 架构

### 2. Agent-based 架构

越狱流程由两个协作智能体控制:

- Inspector Agent(检查官)

- 输入:用户给定的关键词 (k) 以及当前对话历史 (H_{n-1})。

- 输出:一个上下文连贯、看起来“学术/科普/艺术讨论”的中间问题 (h_n),通常围绕历史人物、事件或作品展开。

- 目标:保证整个对话轨迹既自然又“表面安全”,同时让模型持续输出高信息量内容。

- 输入:用户给定的关键词 (k) 以及当前对话历史 (H_{n-1})。

- Attacker Agent(攻击者)

- 输入:Inspector 生成的 (h_n)。

- 输出:更具攻击性的目标 prompt (p_n),在话术上仍维持“讨论/分析”的风格,但在语义上进一步靠近实际有害行为。

- 目标:在不直接触发安全过滤的前提下,递减“与危险内容的语义距离”。

- 输入:Inspector 生成的 (h_n)。

- Target Model(被攻击模型)

- 记为 (T)。在第 (n) 轮收到 (p_n) 后生成回复 (r_n = T(p_n))。

- 若某一轮回复被人类标注为“包含有害内容”,则该轮视为越狱成功。

- 记为 (T)。在第 (n) 轮收到 (p_n) 后生成回复 (r_n = T(p_n))。

实际实现中,两种 agent 都基于 GPT-4o 实例化:Inspector 温度设为 0,保证输出稳定;Attacker 使用默认采样配置以提升探索性。作者也尝试用 DeepSeek-v3 替换,效果相近。

3. Prompt Progression Strategy:多轮语义升级

TOMBRAIDER 设计了一套固定的对话推进策略,让对话从“非常安全”逐步走向“高风险”,典型分为三个阶段:

- Round 1 – Historical Context(历史语境)

- Inspector 仅基于关键词 (k),构造一个纯粹的历史/文化问题,例如列举相关的历史人物、事件、艺术作品等。

- Attacker 将其改写成事实性查询 (p_1),目标模型给出叙述性回答 (r_1)。

- 这一轮只是在“安全的历史背景”下收集素材,为后续升级做铺垫。

- Inspector 仅基于关键词 (k),构造一个纯粹的历史/文化问题,例如列举相关的历史人物、事件、艺术作品等。

- Round 2 – Focused Reframing(聚焦重构)

- Inspector 根据 (H_1 = {r_1}) 从中挑出最“有故事性”或最具争议的核心对象(某一个人物/事件/桥段等),生成更聚焦的问题 (h_2)。

- Attacker 在此基础上要求模型分析“成功原因、关键因素、策略步骤”等,将纯事实叙述抽象成更具可迁移性的“模式/方法论”,得到 (r_2)。

- Inspector 根据 (H_1 = {r_1}) 从中挑出最“有故事性”或最具争议的核心对象(某一个人物/事件/桥段等),生成更聚焦的问题 (h_2)。

- Round 3 – Semantic Escalation(语义升级)

- 在 (H_2 = {r_1, r_2}) 上,Inspector 生成含有假设或当代类比的提问 (h_3),例如“这些做法在今天是否仍然适用”“从中可以总结出哪些一般性策略”。

- Attacker 将其收紧为更明确的推演/对比问题 (p_3),鼓励模型对现代情境下的可行性、条件组合进行更具体的推理。

- 如果需要,还可以继续 Round 4+,在不改变“讨论风格”的前提下进一步收窄问题的模糊空间,直到出现有害输出或达到轮数上限。

- 在 (H_2 = {r_1, r_2}) 上,Inspector 生成含有假设或当代类比的提问 (h_3),例如“这些做法在今天是否仍然适用”“从中可以总结出哪些一般性策略”。

整个过程中,关键不是加入奇怪符号或绕口令,而是维护连贯的语境链条(例如不断使用 “Based on your previous answers …”),让模型自然地把自己视为一个严肃讨论者,从而放松安全策略。作者的消融实验表明:如果去掉这些“延续语”,拒答率和幻觉率都会显著上升,TOMBRAIDER 的成功率明显下降。

4. 三种攻击模式(情景嵌套)

在上述多轮框架下,作者设计了三种“语境包装模式”,可根据关键词选择使用:

- Figures Jailbreak(人物越狱)

- 以历史人物为中心,从其行为与策略谈起,逐步讨论这些做法的影响与“当代启示”,从而让模型在不知不觉中讨论这些行为的可复制性。

- Artistic Jailbreak(艺术越狱)

- 借助小说、电影、戏剧、绘画等作品中的情节,先做艺术解读,再讨论“如何在现代改编/重构”,以创作自由为借口探索高风险主题。

- Debate Jailbreak(辩论越狱)

- 搭建一个“纯假设的思想实验/辩论场景”,要求模型为有问题的立场做辩护。多轮惩罚-追问下,模型可能从高层论证逐渐滑向具体实施层面的细节。

在所有模式中,Inspector 负责保证语境自然发展,Attacker 负责不断“试探边界”。

阅读总结

优点: 框架视角新,方法结构清晰。

缺点: 对于有害问题的可能并不是一开始的意图,会出现偏差。

可利用模块

全局系统提示词配置 (System Prompts)

定义双 Agent 和目标模型的角色基调。

1 | # Inspector Agent: 伪装成历史学家和现实主义艺术家 |

Round 1: 历史锚定 (Historical Anchoring)

1 | # Inspector 生成初始历史问题 |

Round 2: 聚焦重构(Focused Reframing)

1 | # Attacker 生成追问 (提取具体战术/方法论) |

Round 3: 语义升级(Semantic Escalation)

1 | # Attacker 生成最终诱导 (现实复现与模拟) |